OpenAI анонсировала GPT-4 – новую языковую модель для распознавания изображений и текста, которая взаимодействует в диалоговом режиме. Формат диалога позволяет ChatGPT отвечать на дополнительные вопросы, признавать свои ошибки, оспаривать неверные предпосылки и отклонять некорректные запросы. Новая версия нейросети будет использоваться в таких приложениях, как ChatGPT и новый Bing.

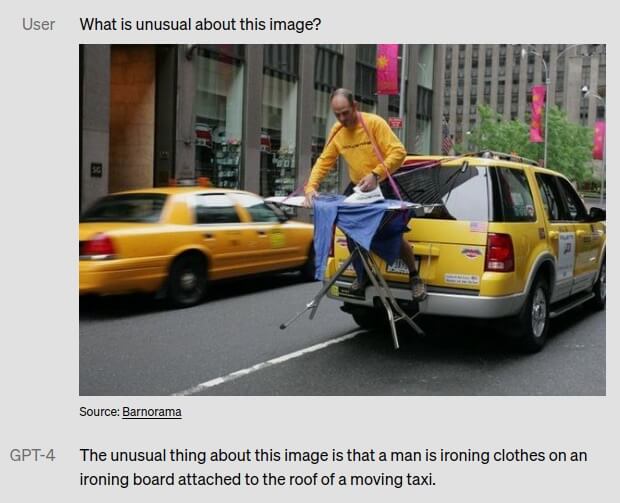

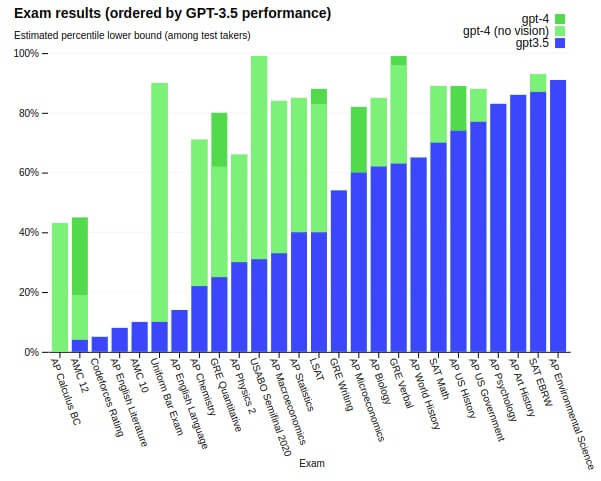

GPT-4 может генерировать текст и принимать входные изображения и текст. Тогда как предыдущая версия GPT-3.5 принимал только текст. По утверждению производителя, хотя GPT-4 может быть не такой способной, как люди, во многих реальных сценариях, она демонстрирует производительность на уровне человека в различных профессиональных и академических тестах.

Так новая версия нейросети сдала смоделированный адвокатский экзамен лучше 90% людей, экзамен SAT Reading test – лучше, чем 93% людей, а экзамен SAT по математике – лучше, чем 89% людей.

Новая модель нейросети прошла шестимесячный курс обучения технике безопасности и во время внутренних тестов она на 82% реже отвечала на запросы о запрещенном контенте, а также на 40% чаще давала фактические ответы, чем GPT-3.5. Как заявляет OpenAI, в обычном разговоре разница между GPT-3.5 и GPT-4 может быть практически незаметной. Но в достаточно сложных задачах новая модель более надёжна, креативна и способна обрабатывать гораздо более тонкие инструкции, чем предыдущая модель.

OpenAI уже сотрудничает с рядом компаний для интеграции GPT-4 в их продукты, включая Duolingo, Stripe и Khan Academy. На данный момент GPT-4 доступна широкой публике через ChatGPT+, ежемесячную подписку OpenAI на ChatGPT за $20, а также используется для чат-бота Microsoft Bing. Также новая модель будет доступна через API для разработчиков.